ControlNet V1.1 其它类型的 ControlNet 模型的工作流也与都与本篇示例相同,你只需要根据需要选择对应的模型和上传对应的参考图即可。

ControlNet 图片预处理相关说明

不同类型的 ControlNet 模型,通常需要使用不同类型的参考图:

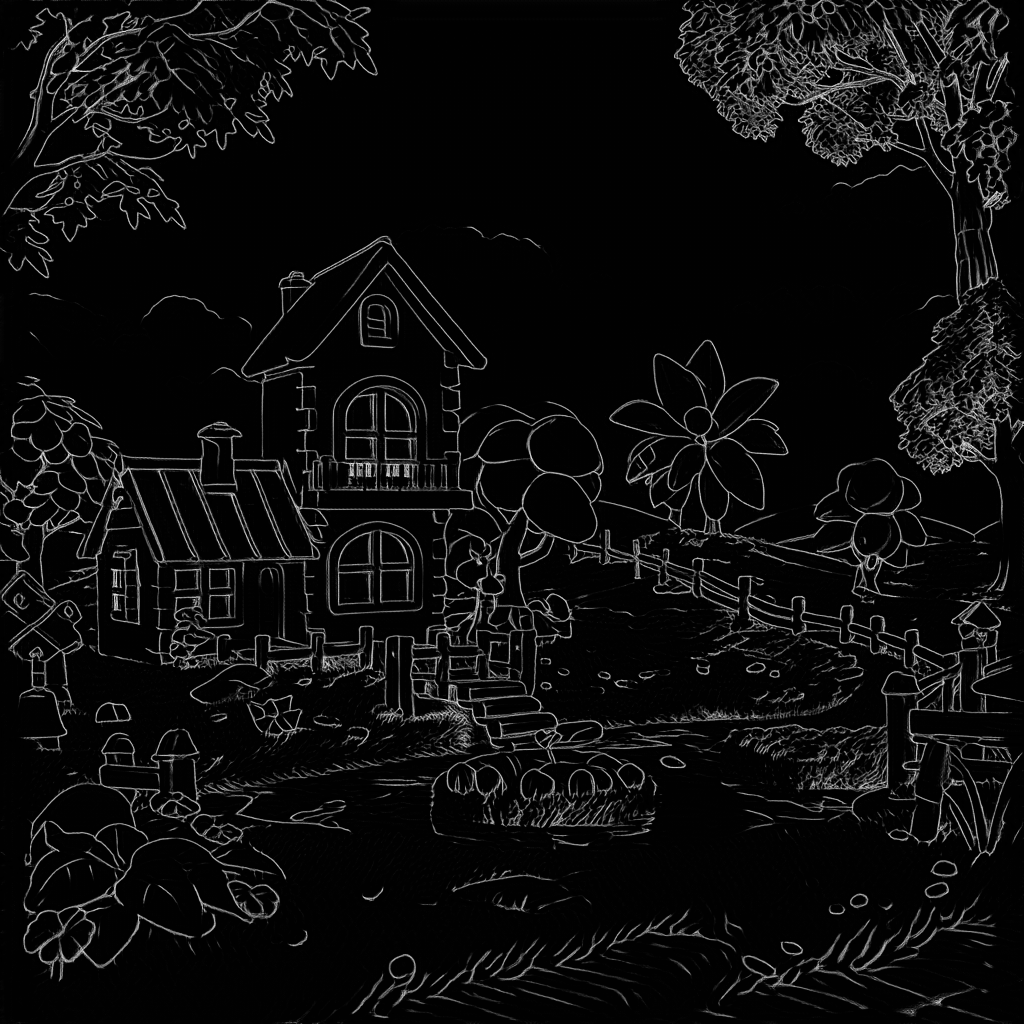

图源:ComfyUI ControlNet aux由于目前 Comfy Core 节点中,不包含所有类型的 预处理器 类型,但在本文档的实际示例中,我们都将提供已经经过处理后的图片, 但在实际使用过程中,你可能需要借助一些自定义节点来对图片进行预处理,以满足不同 ControlNet 模型的需求,下面是一些相关的插件

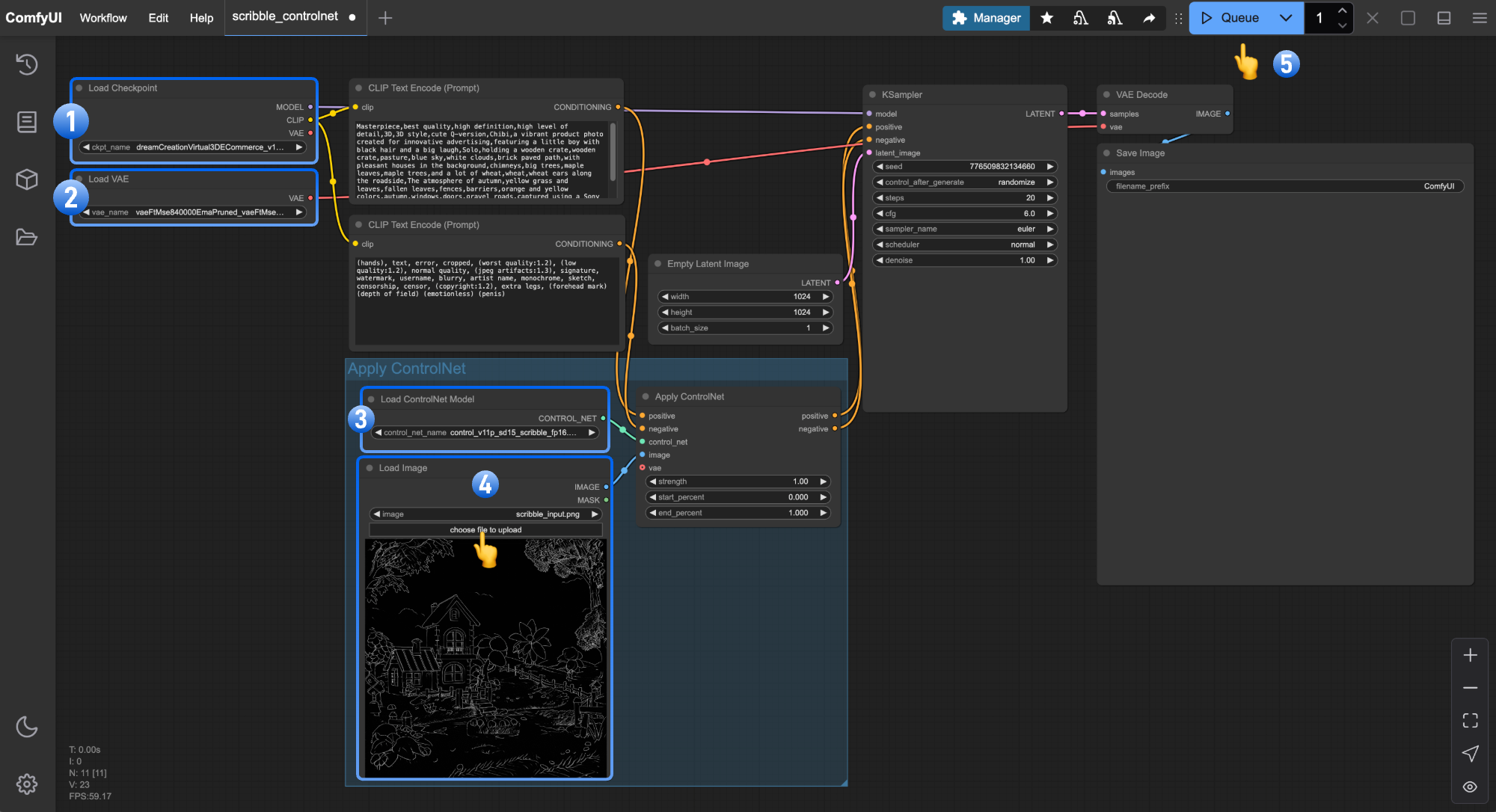

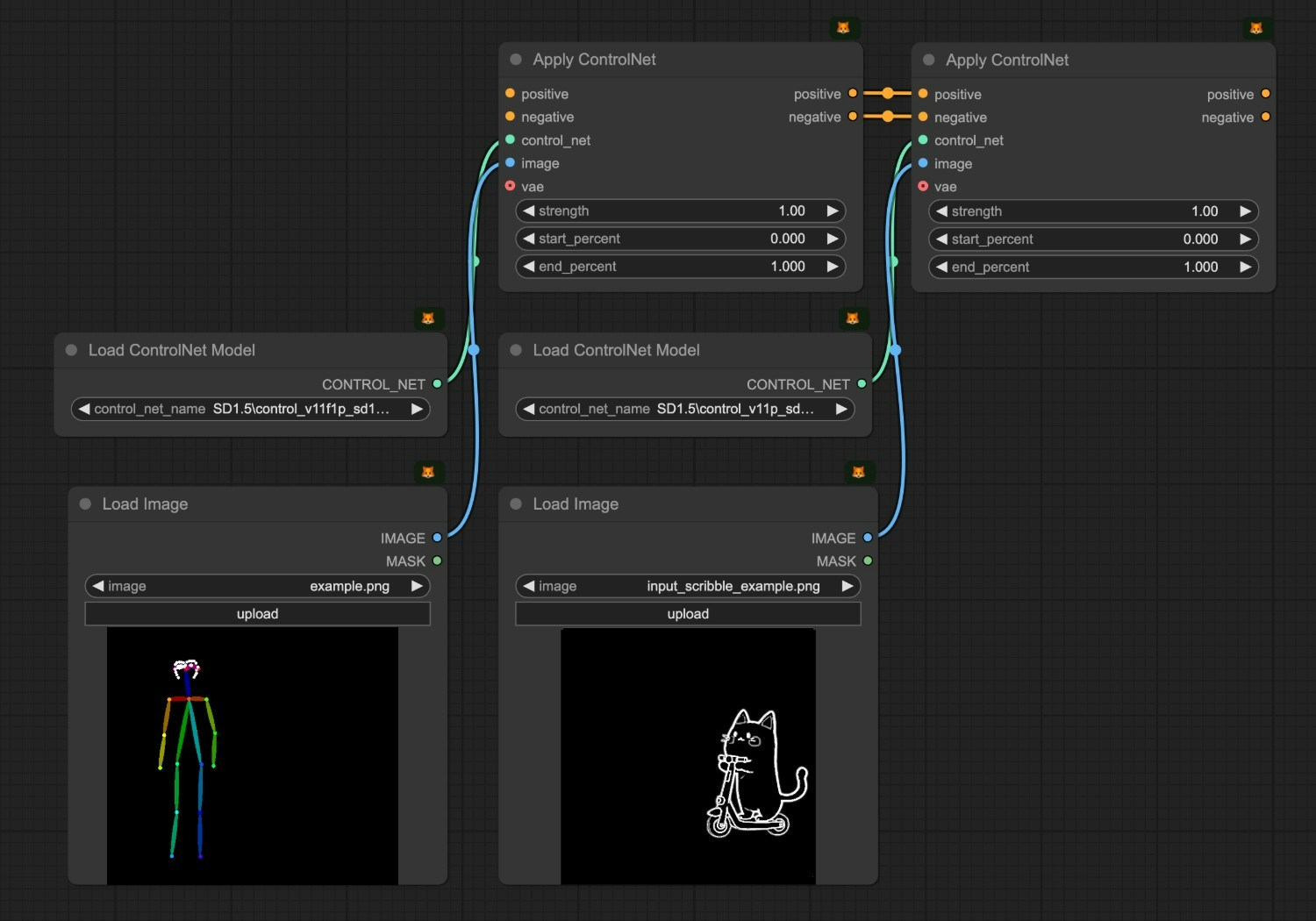

ComfyUI ControlNet 工作流示例讲解

1. ControlNet 工作流素材

请下载下面的工作流图片,并拖入 ComfyUI 以加载工作流

Metadata 中包含工作流 json 的图片可直接拖入 ComfyUI 或使用菜单

Workflows -> Open(ctrl+o) 来加载对应的工作流。

该图片已包含对应模型的下载链接,直接拖入 ComfyUI 将会自动提示下载。

2. 手动模型安装

如果你网络无法顺利完成对应模型的自动下载,请尝试手动下载下面的模型,并放置到指定目录中

- dreamCreationVirtual3DECommerce_v10.safetensors

- vae-ft-mse-840000-ema-pruned.safetensors

- control_v11p_sd15_scribble_fp16.safetensors

本示例中 vae 模型也可以使用 dreamCreationVirtual3DECommerce_v10.safetensors 模型中的 vae 模型,这里我们遵循模型作者建议使用单独的 vae 模型。

3. 按步骤完成工作流的运行

- 确保

Load Checkpoint可以加载 dreamCreationVirtual3DECommerce_v10.safetensors - 确保

Load VAE可以加载 vae-ft-mse-840000-ema-pruned.safetensors - 在

Load Image中点击Upload上传之前提供的输入图片 - 确保

Load ControlNet可以加载 control_v11p_sd15_scribble_fp16.safetensors - 点击

Queue按钮,或者使用快捷键Ctrl(cmd) + Enter(回车)来执行图片的生成

相关节点讲解

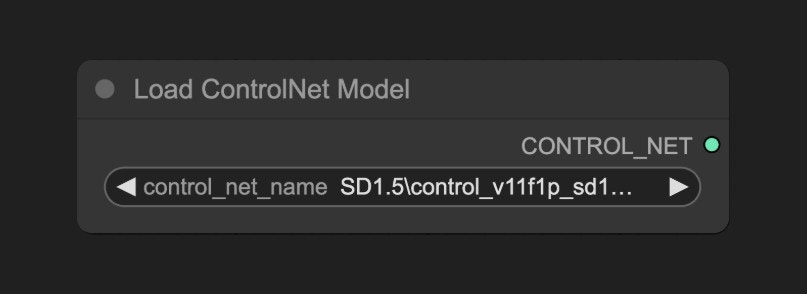

Load ControlNet 节点讲解

ComfyUI\models\controlnet 的模型会被 ComfyUI 检测到,并在这个节点中识别并加载

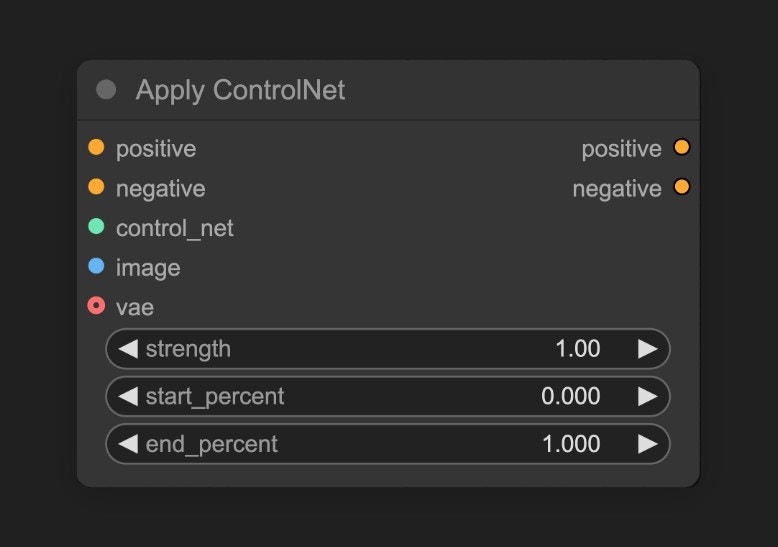

Apply ControlNet 节点讲解

load controlnet 加载的 ControlNet 模型,并根据输入的图片,生成对应的控制条件。

输入类型

| 参数名称 | 作用 |

|---|---|

positive | 正向条件 |

negative | 负向条件 |

control_net | 要应用的controlNet模型 |

image | 用于 controlNet 应用参考的预处理器处理图片 |

vae | Vae模型输入 |

strength | 应用 ControlNet 的强度,越大则 ControlNet 对生成图像的影响越大 |

start_percent | 确定开始应用controlNet的百分比,比如取值0.2,意味着ControlNet的引导将在扩散过程完成20%时开始影响图像生成 |

end_percent | 确定结束应用controlNet的百分比,比如取值0.8,意味着ControlNet的引导将在扩散过程完成80%时停止影响图像生成 |

| 参数名称 | 作用 |

|---|---|

positive | 应用了 ControlNet 处理后的正向条件数据 |

negative | 应用了 ControlNet 处理后的负向条件数据 |

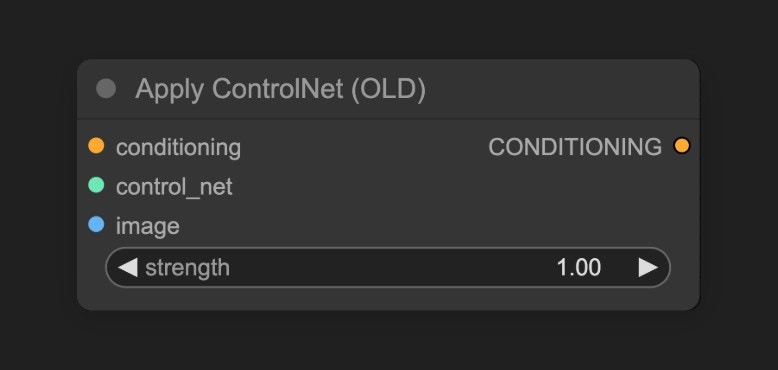

你也许会在有些早期的工作流中看到如下的

Apply ControlNet(Old) 节点,这个节点是早期 ControlNet 的节点,目前已弃用状态,默认在搜索和节点列表不可见

Show deprecated nodes in search 选项,推荐使用新节点开始你的尝试

- 试着制作类似的涂鸦图片,甚至自己手绘,并使用 ControlNet 模型生成图像,体验 ControlNet 带来的乐趣

- 调整 Apply ControlNet 节点的

Control Strength参数,来控制 ControlNet 模型对生成图像的影响 - 访问 ControlNet-v1-1_fp16_safetensors 仓库下载其它类型的 ControlNet 模型,并尝试使用它们生成图像