HiDream-I1 是智象未来(HiDream-ai)于2025年4月7日正式开源的文生图模型。该模型拥有17B参数规模,采用 MIT 许可证 发布,支持用于个人项目、科学研究以及商用,目前在多项基准测试中该模型表现优异。

HiDream-I1 是智象未来(HiDream-ai)于2025年4月7日正式开源的文生图模型。该模型拥有17B参数规模,采用 MIT 许可证 发布,支持用于个人项目、科学研究以及商用,目前在多项基准测试中该模型表现优异。

模型特点

混合架构设计 采用扩散模型(DiT)与混合专家系统(MoE)的结合架构:- 主体基于Diffusion Transformer(DiT),通过双流MMDiT模块处理多模态信息,单流DiT模块优化全局一致性。

- 动态路由机制灵活分配计算资源,提升复杂场景处理能力,在色彩还原、边缘处理等细节上表现优异。

- OpenCLIP ViT-bigG、OpenAI CLIP ViT-L(视觉语义对齐)

- T5-XXL(长文本解析)

- Llama-3.1-8B-Instruct(指令理解) 这一组合使其在颜色、数量、空间关系等复杂语义解析上达到SOTA水平,中文提示词支持显著优于同类开源模型。

- 完整版本:🤗 HiDream-I1-Full 推理步数为 50

- 蒸馏开发版本:🤗 HiDream-I1-Dev 推理步数为 28

- 蒸馏快速版本:🤗 HiDream-I1-Fast 推理步数为 16

关于本篇工作流示例

我们将在本篇示例中使用 ComfyOrg 的 repackaged 的版本,你可以在 HiDream-I1_ComfyUI 仓库中找到我们将在本篇示例中使用的所有模型文件。HiDream-I1 工作流

对应不同 ComfyUI 原生版本 HiDream-I1 工作流的模型要求基本上是相同的,只有使用过的 diffusion models 文件不同。 如果你不知道如何选择合适的版本,请参考以下建议:- HiDream-I1-Full 可以生成质量最高的图像

- HiDream-I1-Dev 在生成较高质量的图像的同时,又兼顾速度

- HiDream-I1-Fast 只需要 16 步就可以生成图像,适合需要实时迭代的场景

cfg 参数为 1.0,我们对应参数设置已在相关工作流中备注。

模型安装

下面的模型文件是我们会共用的模型文件,请点击对应的链接进行下载,并参照模型文件保存位置进行保存,对应的 diffusion models 模型我们会在对应工作流中引导你进行下载。 text_encoders:- clip_l_hidream.safetensors

- clip_g_hidream.safetensors

- t5xxl_fp8_e4m3fn_scaled.safetensors 这个模型在许多的工作流中都有使用过,你可能已经下载了这个文件。

- llama_3.1_8b_instruct_fp8_scaled.safetensors

- ae.safetensors 这个是 Flux 的 VAE 模型,如果你之前使用过 Flux 的工作流,你可能已经下载了这个文件。

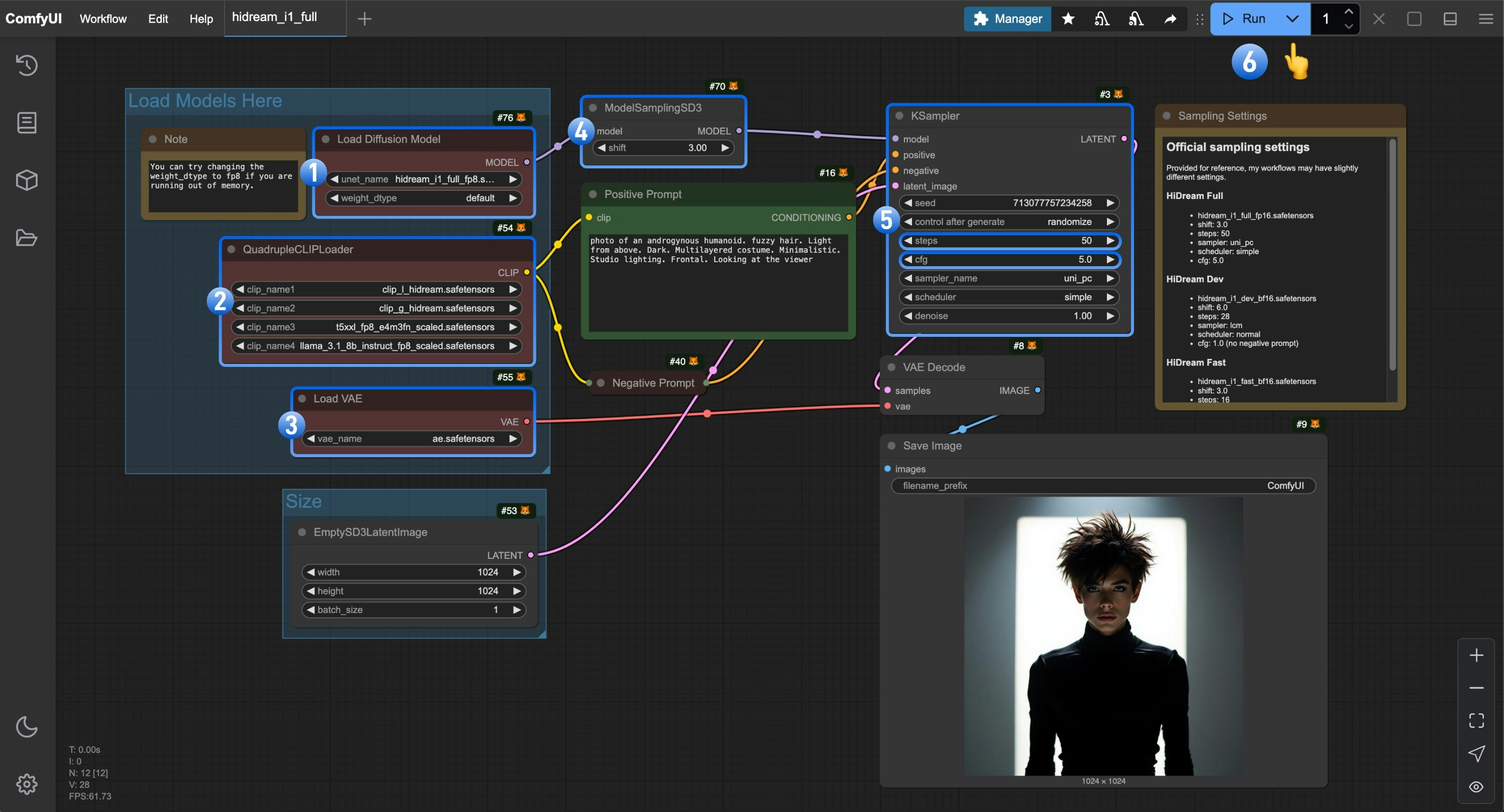

HiDream-I1 full 版本工作流

Run on Comfy Cloud

1. 模型文件下载

请根据你的硬件情况选择合适的版本,点击链接并下载对应的模型文件保存到ComfyUI/models/diffusion_models/ 文件夹下。

- FP8 版本:hidream_i1_full_fp8.safetensors 需要 16GB 以上的显存

- 完整版本:hidream_i1_full_f16.safetensors 需要 27GB 以上的显存

2. 工作流文件下载

请下载下面的图片,并拖入 ComfyUI 中以加载对应的工作流

3. 按步骤完成工作流的运行

- 确保

Load Diffusion Model节点中使用的是hidream_i1_full_fp8.safetensors文件 - 确保

QuadrupleCLIPLoader中四个对应的 text encoder 被正确加载- clip_l_hidream.safetensors

- clip_g_hidream.safetensors

- t5xxl_fp8_e4m3fn_scaled.safetensors

- llama_3.1_8b_instruct_fp8_scaled.safetensors

- 确保

Load VAE节点中使用的是ae.safetensors文件 - 对于 full 版本你需要设置

ModelSamplingSD3中的shift参数为3.0 - 对于

Ksampler节点,你需要进行以下设置steps设置为50cfg设置为5.0- (可选)

sampler设置为lcm - (可选)

scheduler设置为normal

- 点击

Run按钮,或者使用快捷键Ctrl(cmd) + Enter(回车)来执行图片生成

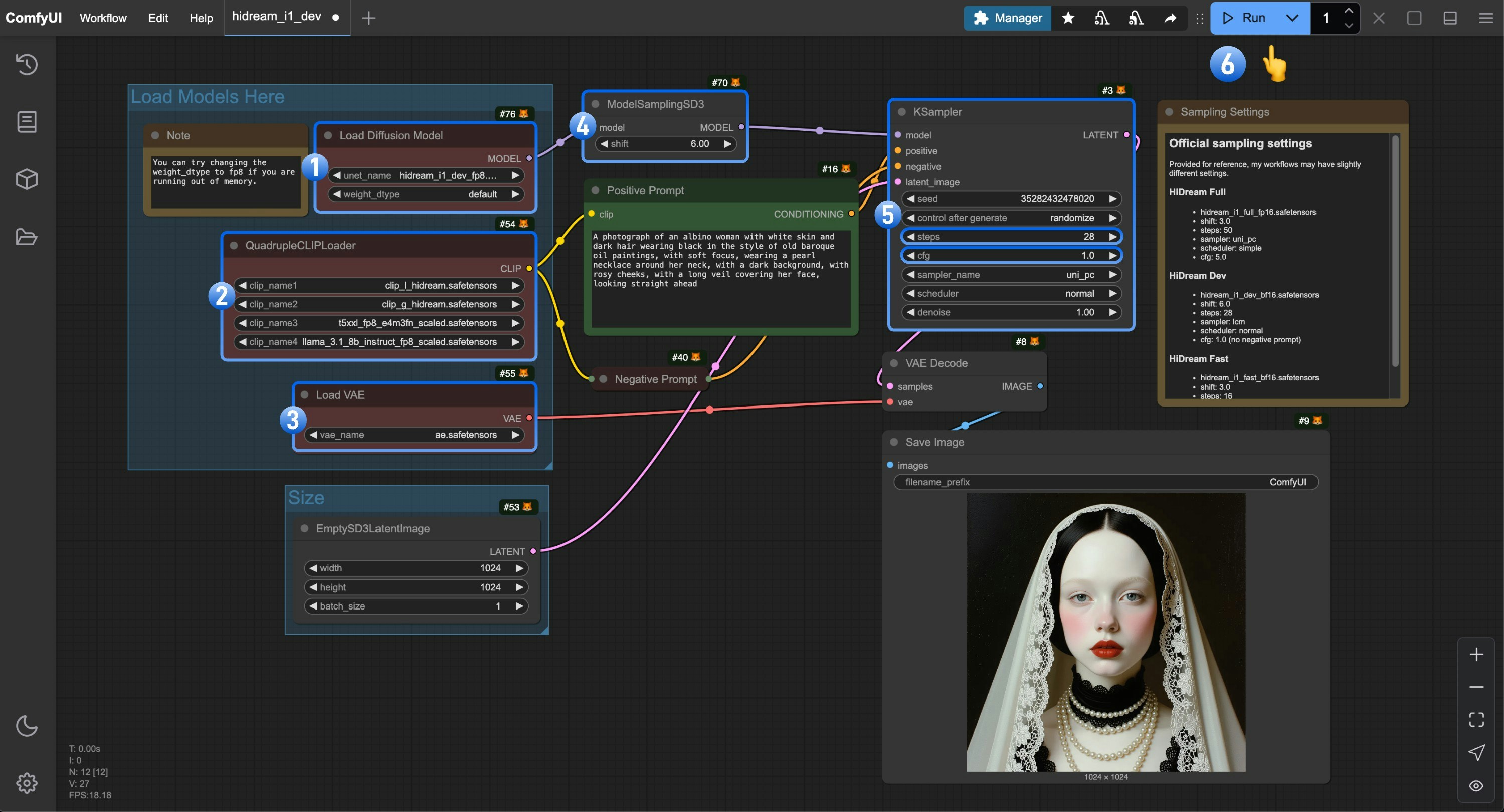

HiDream-I1 dev 版本工作流

Run on Comfy Cloud

1. 模型文件下载

请根据你的硬件情况选择合适的版本,点击链接并下载对应的模型文件保存到ComfyUI/models/diffusion_models/ 文件夹下。

- FP8 版本:hidream_i1_dev_fp8.safetensors 需要 16GB 以上的显存

- 完整版本:hidream_i1_dev_bf16.safetensors 需要 27GB 以上的显存

2. 工作流文件下载

请下载下面的图片,并拖入 ComfyUI 中以加载对应的工作流

3. 按步骤完成工作流的运行

- 确保

Load Diffusion Model节点中使用的是hidream_i1_dev_fp8.safetensors文件 - 确保

QuadrupleCLIPLoader中四个对应的 text encoder 被正确加载- clip_l_hidream.safetensors

- clip_g_hidream.safetensors

- t5xxl_fp8_e4m3fn_scaled.safetensors

- llama_3.1_8b_instruct_fp8_scaled.safetensors

- 确保

Load VAE节点中使用的是ae.safetensors文件 - 对于 dev 版本你需要设置

ModelSamplingSD3中的shift参数为6.0 - 对于

Ksampler节点,你需要进行以下设置steps设置为28- (重要)

cfg设置为1.0 - (可选)

sampler设置为lcm - (可选)

scheduler设置为normal

- 点击

Run按钮,或者使用快捷键Ctrl(cmd) + Enter(回车)来执行图片生成

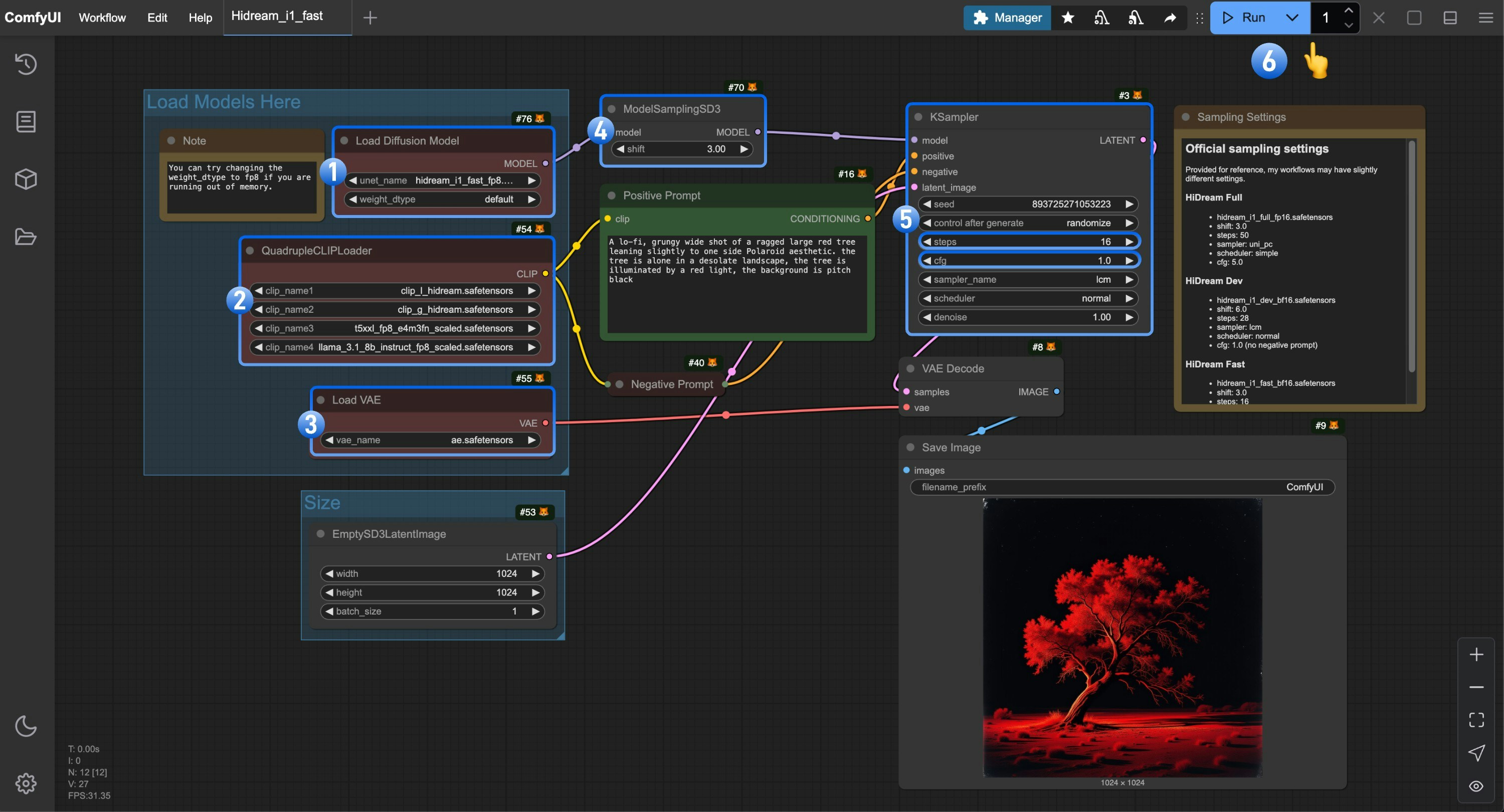

HiDream-I1 fast 版本工作流

Run on Comfy Cloud

1. 模型文件下载

请根据你的硬件情况选择合适的版本,点击链接并下载对应的模型文件保存到ComfyUI/models/diffusion_models/ 文件夹下。

- FP8 版本:hidream_i1_fast_fp8.safetensors 需要 16GB 以上的显存

- 完整版本:hidream_i1_fast_bf16.safetensors 需要 27GB 以上的显存

2. 工作流文件下载

请下载下面的图片,并拖入 ComfyUI 中以加载对应的工作流

3. 按步骤完成工作流的运行

- 确保

Load Diffusion Model节点中使用的是hidream_i1_fast_fp8.safetensors文件 - 确保

QuadrupleCLIPLoader中四个对应的 text encoder 被正确加载- clip_l_hidream.safetensors

- clip_g_hidream.safetensors

- t5xxl_fp8_e4m3fn_scaled.safetensors

- llama_3.1_8b_instruct_fp8_scaled.safetensors

- 确保

Load VAE节点中使用的是ae.safetensors文件 - 对于 fast 版本你需要设置

ModelSamplingSD3中的shift参数为3.0 - 对于

Ksampler节点,你需要进行以下设置steps设置为16- (重要)

cfg设置为1.0 - (可选)

sampler设置为lcm - (可选)

scheduler设置为normal

- 点击

Run按钮,或者使用快捷键Ctrl(cmd) + Enter(回车)来执行图片生成

使用建议

- 虽然 HiDream-I1 支持中文提示词,但建议还是优先使用英文提示词来保证准确性

- 你可以使用 fast 版本来快速生成示例验证,然后再用完整版本的模型来生成较高质量的图像

其它相关资源

GGUF 版本模型

你需要使用 City96 的 ComfyUI-GGUF 中的Unet Loader (GGUF)节点替换掉 Load Diffusion Model 节点来使用 GGUF 版本模型。

NF4 版本模型

- HiDream-I1-nf4

- 使用 ComfyUI-HiDream-Sampler 节点来使用 NF4 版本模型。