- 多模态控制:支持多种控制条件,包括 Canny(线稿)、Depth(深度)、OpenPose(人体姿势)、MLSD(几何边缘) 等,同时支持使用 轨迹控制

- 高质量视频生成:基于 Wan2.2 架构,输出影视级质量视频

- 多语言支持:支持中英文等多语言提示词输入

ComfyOrg Wan2.2 Fun InP & Control Youtube 直播回放

对于 ComfyUI Wan2.2 的使用,我们有进行了直播,你可以查看这些回放了解如何使用Wan2.2 Fun Control 视频控制生成工作流示例

这里提供的工作流包含了两个版本:- 使用了 lightx2v 的 Wan2.2-Lightning 4 步 LoRA : 但可能导致生成的视频动态会有损失,但速度会更快

- 没有使用加速 LoRA 的 fp8_scaled 版本

| 模型类型 | 分辨率 | 显存占用 | 首次生成时长 | 第二次生成时长 |

|---|---|---|---|---|

| fp8_scaled | 640×640 | 83% | ≈ 524秒 | ≈ 520秒 |

| fp8_scaled + 4步LoRA加速 | 640×640 | 89% | ≈ 138秒 | ≈ 79秒 |

1. 工作流及素材下载

下载下面的视频或者 JSON 文件并拖入 ComfyUI 中以加载对应的工作流下载 JSON 格式工作流

请下载下面的图片及视频,我们将作为输入。

这里我们使用了经过预处理的视频, 可以直接用于控制视频生成

2. 手动下载模型

下面的模型你可以在 Wan_2.2_ComfyUI_Repackaged 找到 Diffusion Model- wan2.2_fun_control_high_noise_14B_fp8_scaled.safetensors

- wan2.2_fun_control_low_noise_14B_fp8_scaled.safetensors

- wan2.2_i2v_lightx2v_4steps_lora_v1_high_noise.safetensors

- wan2.2_i2v_lightx2v_4steps_lora_v1_low_noise.safetensors

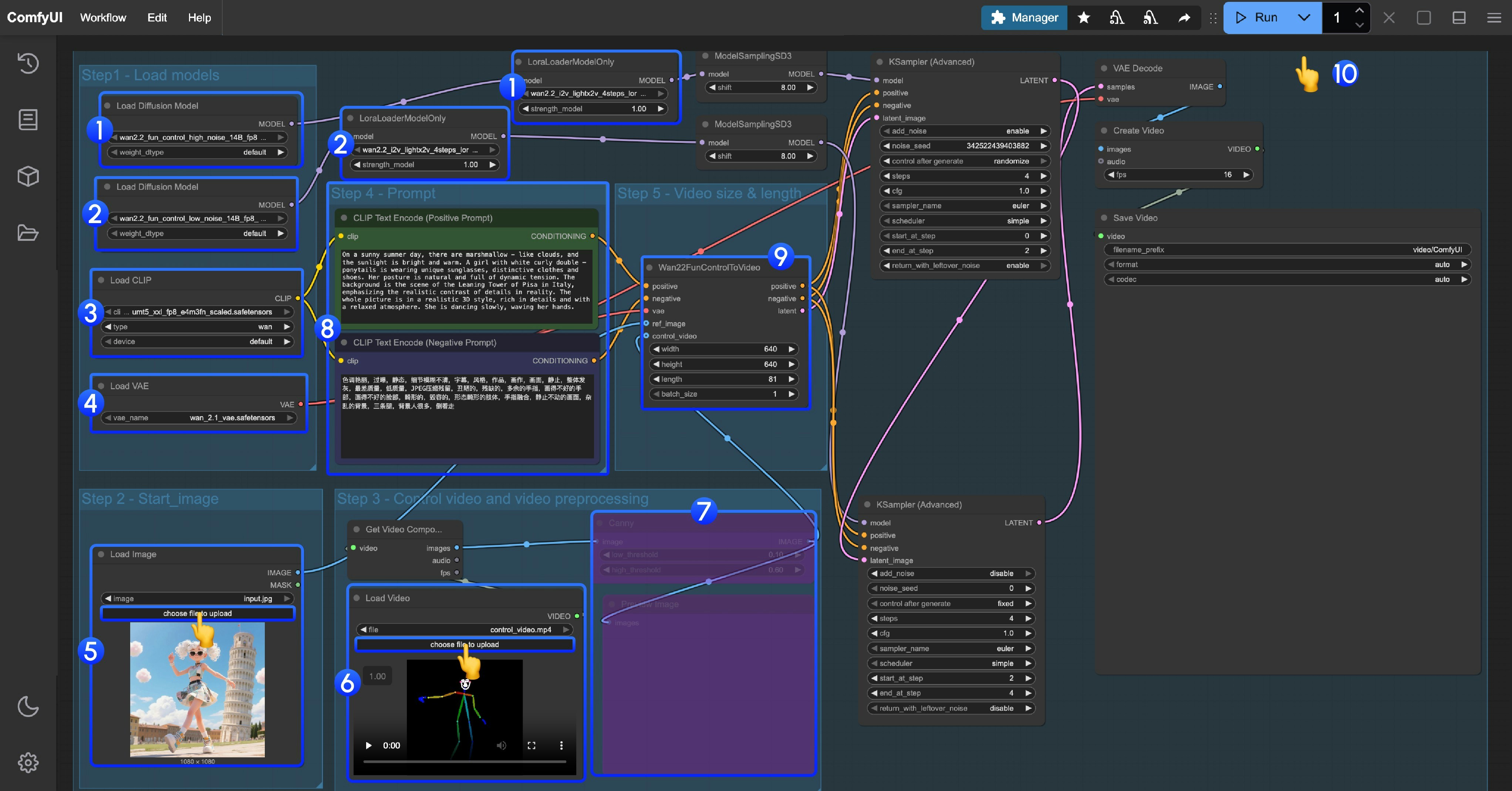

3. 按步骤完成工作流

这个工作流是使用了 LoRA 的工作流,请确保对应的 Diffusion model 和 LoRA 是一致的, high noise 和 low noise 的模型和 LoRA 需要对应使用

- High noise 模型及 LoRA 加载

- 确保

Load Diffusion Model节点加载了wan2.2_fun_control_high_noise_14B_fp8_scaled.safetensors模型 - 确保

LoraLoaderModelOnly节点加载了wan2.2_i2v_lightx2v_4steps_lora_v1_high_noise.safetensors

- Low noise 模型及 LoRA 加载

- 确保

Load Diffusion Model节点加载了wan2.2_fun_control_low_noise_14B_fp8_scaled.safetensors模型 - 确保

LoraLoaderModelOnly节点加载了wan2.2_i2v_lightx2v_4steps_lora_v1_low_noise.safetensors

- 确保

Load CLIP节点加载了umt5_xxl_fp8_e4m3fn_scaled.safetensors模型 - 确保

Load VAE节点加载了wan_2.1_vae.safetensors模型 - 在

Load Image节点上传起始帧 - 在第二个

Load video节点控制视频的 pose 视频, 提供的视频已经经过预处理可以直接使用 - 由于我们提供的视频是预处理过的 pose 视频,所以对应的视频图像预处理节点需要禁用,你可以选中后使用 Ctrl + B` 来禁用

- 修改 Prompt 使用中英文都可以

- 在

Wan22FunControlToVideo修改对应视频的尺寸, 默认设置了 640*640 的分辨率来避免低显存用户使用这个工作流时过于耗时 - 点击

Run按钮,或者使用快捷键Ctrl(cmd) + Enter(回车)来执行视频生成